Hadoop分布式文件系统和对象存储有何不同?

最近在Quora上有人提到一个问题,有关Hadoop分布式文件系统和OpenStack对象存储的不同。

问题原文如下:

“HDFS (Hadoop分布式文件系统)和OpenStack对象存储(OpenStack Object Storage)似乎都有着相似的目的:实现冗余、快速、联网的存储。什么样的技术特性让这两种系统因而不一样?这两种存储系统最后趋于融合是否大有意义?”

问题提出之后,很快有OpenStack的开发者进行了回复。这篇文章在此摘抄了前两名回复进行翻译,以供各位参考。

排名第一的答案来自RackSpace的OpenStack Swift开发者Chuck Their:

虽然HDFS与Openstack对象存储(Swift)之间有着一些相似之处,但是这两种系统的总体设计却大不一样。

1. HDFS使用了中央系统来维护文件元数据(Namenode,名称节点),而在Swift中,元数据呈分布式,跨集群复制。使用一种中央元数据系统对HDFS来说无异于单一故障点,因而扩展到规模非常大的环境显得更困难。

2. Swift在设计时考虑到了多租户架构,而HDFS没有多租户架构这个概念。

3. HDFS针对更庞大的文件作了优化(这是处理数据时通常会出现的情况),Swift被设计成了可以存储任何大小的文件。

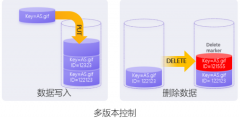

4. 在HDFS中,文件写入一次,并且每次只能有一个文件写入;而在Swift中,文件可以写入多次;在并发操作环境下,以最近一次操作为准。

5. HDFS用Java来编写,而Swift用Python来编写。

另外,HDFS被设计成了可以存储数量中等的大文件,以支持数据处理,而Swift被设计成了一种比较通用的存储解决方案,能够可靠地存储数量非常多的大小不一的文件。

排名第二的答案来自Joshua McKenty,他是美国宇航局Nebula云计算项目的首席架构师,是OpenStack Nova软件的早期开发者之一,当前是OpenStack项目监管委员会的成员,还是Piston.cc这家基于OpenStack的公司的创始人。

Chuck刚才详细介绍了两者的技术差异,但是没有讨论两者可想而知的融合,OpenStack设计峰会上抛出了融合这个话题。简而言之,HDFS被设计成可以使用Hadoop,跨存储环境里面的对象实现MapReduce处理。对于许多OpenStack公司(包括我自己的公司)来说,支持Swift里面的处理是路线图上面的一个目标,不过不是每个人都认为MapReduce是解决之道。

我们已讨论过为HDFS编写包装器,这将支持OpenStack内部存储应用编程接口(API),并且让用户可以针对该数据来执行Hadoop查询。还有一个办法就是在Swift里面使用HDFS。但是这些方法似乎没有一个是理想的。

OpenStack社区方面也在开展研究开发方面的一些工作,认真研究其他替代性的MapReduce框架(Riak和CouchDB等)。

最后,现在有别的一些存储项目,当前“隶属于”OpenStack社区(SheepDog和HC2)。充分利用数据局部性,并且让对象存储变得“更智能”,这是预计会取得进步的一个领域。

站内头条

-

Spectra Logic 通过企业级 LTO-10 支持推进永久归档战略

2025-05-29 -

JetStor 推出适用于企业存储的无限数据平台即服务(DPaaS)

2025-05-29 -

AI推动企业需求大增,下季度SSD价格或将上涨10%

2025-05-29 -

闪迪天花板级PCIe5.0 SSD上市,性能与能效均位于行业前沿

2025-05-29 -

车载数据存储需求愈来愈高,车规级UFS 4.0将变得愈发重要

2025-05-20